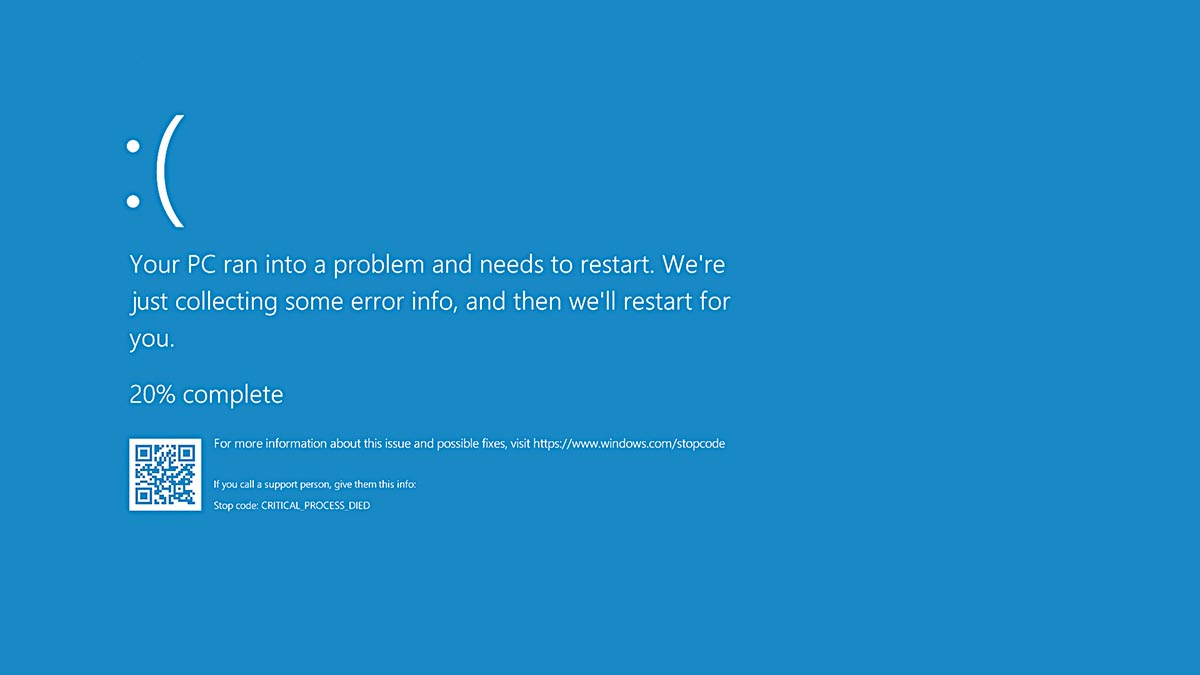

En la mañana del viernes 19 de julio, algunas grandes empresas y agencias de gobierno australianas notaron que muchos de sus sistemas informáticos no estaban funcionando. Con el correr de las horas, a medida que comenzaban las jornadas laborales en todo el mundo, más y más organizaciones veían como les estaba pasando lo mismo: sus computadoras estaban trancadas en un bucle de arranque y mostraban el terror de cualquier responsable de mantenimiento informático, la llamada pantalla azul de la muerte, una pantalla de error de Windows que informa que el sistema tiene un problema grave del que posiblemente no se pueda recuperar. En las horas siguientes los sistemas informáticos de grandes corporaciones, servicios públicos y agencias estatales estuvieron en ascuas.

Durante el viernes hubo mucho trabajo de parte de Microsoft (el problema solo afectó a equipos con Windows), y se encontró que el incidente se debía a un problema con una actualización del paquete de software de ciberseguridad para grandes organizaciones Falcon Sensor, de la empresa estadounidense CrowdStrike. Durante la actualización, que se efectúa de manera automática, uno de los archivos tenía un error, y, debido a que Falcon Sensor tiene acceso al kernel del sistema operativo (el núcleo en el que se dan las operaciones principales), este error impidió el arranque de Windows. Rápidamente, Microsoft y CrowdStrike empezaron a trabajar para resolver el problema y, para el fin de semana, ya tenían pronta una solución, aunque el impacto había sido significativo, con cientos de vuelos cancelados, problemas en hospitales y otros servicios públicos, y algunos bancos y empresas de servicios sin poder operar, entre muchos otros.

Tanto Microsoft como CrowdStrike emitieron comunicados pidiendo disculpas, y Microsoft también responsabilizó a la Unión Europea por haberle exigido que le garantice acceso al kernel de su sistema operativo en 2009, en el marco de las políticas antimonopólicas. Pero, más allá de quién sea responsable por este problema específico, el apagón informático del fin de semana pasado muestra la vulnerabilidad de los sistemas informáticos en los que se basa una parte cada vez más importante del funcionamiento de las sociedades contemporáneas.

Hasta hace algunos años la computación era mayormente local, cada persona u organización tenía sus dispositivos y en ellos estaban almacenados sus archivos e instaladas sus aplicaciones. Con la masificación de la llamada computación en nube, esto ya no sucede más, usamos muchísimas aplicaciones en línea (desde software de administración de empresas hasta procesadores de texto) y los archivos en los que trabajamos están almacenados en servicios de almacenamiento de nube, una nube que no es una cosa liviana y limpia en el cielo, sino cientos de miles de centros de datos llenos de servidores instalados en todo el mundo. Y no es que simplemente cambió la forma en que almacenamos la información, sino que nuestra computación doméstica, empresarial y pública es absolutamente dependiente de los archivos, los datos y las aplicaciones instaladas en esa nube de metal y silicio, por lo que un problema particular puede hacer que no podamos acceder a ellas.

Esta vulnerabilidad derivada de la hiperconectividad, y que involucra a los centros de datos y también a los cables terrestres y submarinos, crece cuando se le agrega gran cantidad de procesos automatizados, sea la actualización automática (como en el caso de Falcon Sensor), la ejecución de procesos de comunicación entre los sistemas locales y la nube o el envío de enormes cantidades de datos que los dispositivos recopilan. Si bien la automatización es una parte central de la computación (a fin de cuentas, una computadora es esencialmente una máquina que ejecuta procesos algorítmicos de manera automática), la escala actual de la automatización vuelve prácticamente imposible hacer una supervisión de los procesos que garantice que funcionen bien y no generen problemas. Pensemos que el incidente con Falcon Sensor tuvo un impacto inmediato y bien claro que permitió identificar rápidamente el problema, pero sería posible que una actualización automática presente un conflicto cuyas consecuencias recién sean observadas tiempo después o que su impacto no se dé en los dispositivos en que se instaló la actualización, sino en otros dispositivos que están conectados a estos; posiblemente, este fallo sería mucho más difícil de identificar y solucionar.

Un tercer factor clave en la vulnerabilidad general que evidencia este apagón es la centralización, pues, si bien la computación contemporánea está distribuida entre miles de millones de dispositivos en todo el mundo, existe una altísima concentración a muchos niveles. La posición dominante que ostenta Microsoft en el mercado de sistemas operativos es uno de los factores que agravó el apagón del fin de semana, y lo mismo se puede decir de CrowdStrike, una empresa que podemos no conocer, pero que opera en un oligopolio en que unas pocas empresas manejan casi todo el mercado de ciberseguridad corporativa. Esto también sucede con los servidores, mercado en el que tres empresas (Amazon, Microsoft y Alphabet) son dueñas del 63 por ciento de los centros de datos, y diez empresas se reparten un 22 por ciento, y esto no solo implica que tienen la información almacenada, sino que definen la operativa de la nube.

Finalmente, es importante señalar que gran parte del software en que se basa la computación contemporánea es privativo, lo que genera dependencia de las corporaciones. E, incluso cuando es de código abierto, no siempre está bien documentado, por lo que es difícil de auditar y analizar por terceros. Esto no solo es crítico en términos de autonomía y soberanía, sino que puede implicar que en el futuro surjan problemas con fragmentos de código escritos hace décadas, pero que siguen estando presentes en los sistemas contemporáneos y que, al no tener documentación clara, sus desarrolladores no puedan colaborar o las empresas ya no existan, sea necesario un esfuerzo enorme de ingeniería inversa para tratar de resolverlos, si es que se puede.

Desde luego, la hiperintegración de la computación contemporánea ha traído muchísimas cosas buenas, desde posibilidades de trabajo compartido a distancia y acceso a entretenimiento hasta mejor acceso a archivos médicos y mayor eficiencia en la planificación industrial. Pero esto no implica que no venga con riesgos, y uno de los más claros es el de que cada vez más un pequeño fallo ponga en jaque a todo el mundo.